Méthodes de recherche en psychologie

On janvier 4, 2022 by adminObjectifs d’apprentissage

- Définir la recherche corrélationnelle et donner plusieurs exemples.

- Expliquer pourquoi un chercheur pourrait choisir de mener une recherche corrélationnelle plutôt qu’une recherche expérimentale ou un autre type de recherche non expérimentale.

- Interpréter la force et la direction de différents coefficients de corrélation.

- Expliquer pourquoi la corrélation n’implique pas la causalité.

Qu’est-ce qu’une recherche corrélationnelle ?

La recherche corrélationnelle est un type de recherche non expérimentale dans lequel le chercheur mesure deux variables (binaires ou continues) et évalue la relation statistique (c’est-à-dire, la corrélation) entre elles avec peu ou pas d’effort pour contrôler les variables étrangères. Il existe de nombreuses raisons pour lesquelles les chercheurs qui s’intéressent aux relations statistiques entre les variables choisissent de mener une étude corrélationnelle plutôt qu’une expérience. La première est qu’ils ne croient pas que la relation statistique soit une relation de cause à effet ou qu’ils ne s’intéressent pas aux relations de cause à effet. Rappelons que les deux objectifs de la science sont de décrire et de prédire et que la stratégie de recherche corrélationnelle permet aux chercheurs d’atteindre ces deux objectifs. Plus précisément, cette stratégie peut être utilisée pour décrire la force et la direction de la relation entre deux variables et s’il existe une relation entre les variables, alors les chercheurs peuvent utiliser les scores d’une variable pour prédire les scores de l’autre (en utilisant une technique statistique appelée régression, qui est discutée plus en détail dans la section sur la corrélation complexe dans ce chapitre).

Une autre raison pour laquelle les chercheurs choisissent d’utiliser une étude corrélationnelle plutôt qu’une expérience est que la relation statistique d’intérêt est considérée comme causale, mais que le chercheur ne peut pas manipuler la variable indépendante parce que c’est impossible, peu pratique ou contraire à l’éthique. Par exemple, si un chercheur peut s’intéresser à la relation entre la fréquence de consommation de cannabis et les capacités de mémorisation, il ne peut pas, pour des raisons éthiques, manipuler la fréquence de consommation de cannabis. En tant que tel, ils doivent s’appuyer sur la stratégie de recherche corrélationnelle ; ils doivent simplement mesurer la fréquence à laquelle les gens consomment du cannabis et mesurer leurs capacités de mémoire à l’aide d’un test de mémoire standardisé, puis déterminer si la fréquence à laquelle les gens consomment du cannabis est statistiquement liée à la performance au test de mémoire.

La corrélation est également utilisée pour établir la fiabilité et la validité des mesures. Par exemple, un chercheur pourrait évaluer la validité d’un bref test d’extraversion en l’administrant à un grand groupe de participants en même temps qu’un test d’extraversion plus long dont la validité a déjà été démontrée. Ce chercheur pourrait ensuite vérifier si les scores des participants au test bref sont fortement corrélés à leurs scores au test plus long. Aucun des résultats du test n’est censé être la cause de l’autre, il n’y a donc pas de variable indépendante à manipuler. En fait, les termes de variable indépendante et de variable dépendante ne s’appliquent pas à ce type de recherche.

Une autre force de la recherche corrélationnelle est qu’elle a souvent une validité externe plus élevée que la recherche expérimentale. Rappelons qu’il existe généralement un compromis entre la validité interne et la validité externe. Plus on ajoute de contrôles aux expériences, plus la validité interne augmente, mais souvent au détriment de la validité externe, car on introduit des conditions artificielles qui n’existent pas dans la réalité. En revanche, les études corrélationnelles ont généralement une faible validité interne car rien n’est manipulé ou contrôlé, mais elles ont souvent une validité externe élevée. Puisque rien n’est manipulé ou contrôlé par l’expérimentateur, les résultats sont plus susceptibles de refléter les relations qui existent dans le monde réel.

Enfin, en prolongement de ce compromis entre validité interne et externe, la recherche corrélationnelle peut aider à fournir des preuves convergentes pour une théorie. Si une théorie est étayée par une véritable expérience dont la validité interne est élevée, ainsi que par une étude corrélationnelle dont la validité externe est élevée, alors les chercheurs peuvent avoir davantage confiance dans la validité de leur théorie. Comme exemple concret, les études corrélationnelles établissant qu’il existe une relation entre le fait de regarder une télévision violente et le comportement agressif ont été complétées par des études expérimentales confirmant que la relation est causale (Bushman & Huesmann, 2001).

La recherche corrélationnelle implique-t-elle toujours des variables quantitatives ?

Une idée fausse courante chez les chercheurs débutants est que la recherche corrélationnelle doit impliquer deux variables quantitatives, comme les scores à deux tests d’extraversion ou le nombre de tracas quotidiens et le nombre de symptômes que les gens ont expérimentés. Cependant, la caractéristique principale de la recherche corrélationnelle est que les deux variables sont mesurées – aucune n’est manipulée – et ceci est vrai que les variables soient quantitatives ou catégorielles. Imaginez, par exemple, qu’un chercheur administre l’échelle d’estime de soi de Rosenberg à 50 étudiants américains et 50 étudiants japonais. Bien que cela ressemble à une expérience inter-sujets, il s’agit d’une étude corrélationnelle car le chercheur n’a pas manipulé la nationalité des étudiants. Il en va de même pour l’étude de Cacioppo et Petty qui compare les professeurs d’université et les ouvriers d’usine en termes de besoin de cognition. Il s’agit d’une étude corrélationnelle car les chercheurs n’ont pas manipulé la profession des participants.

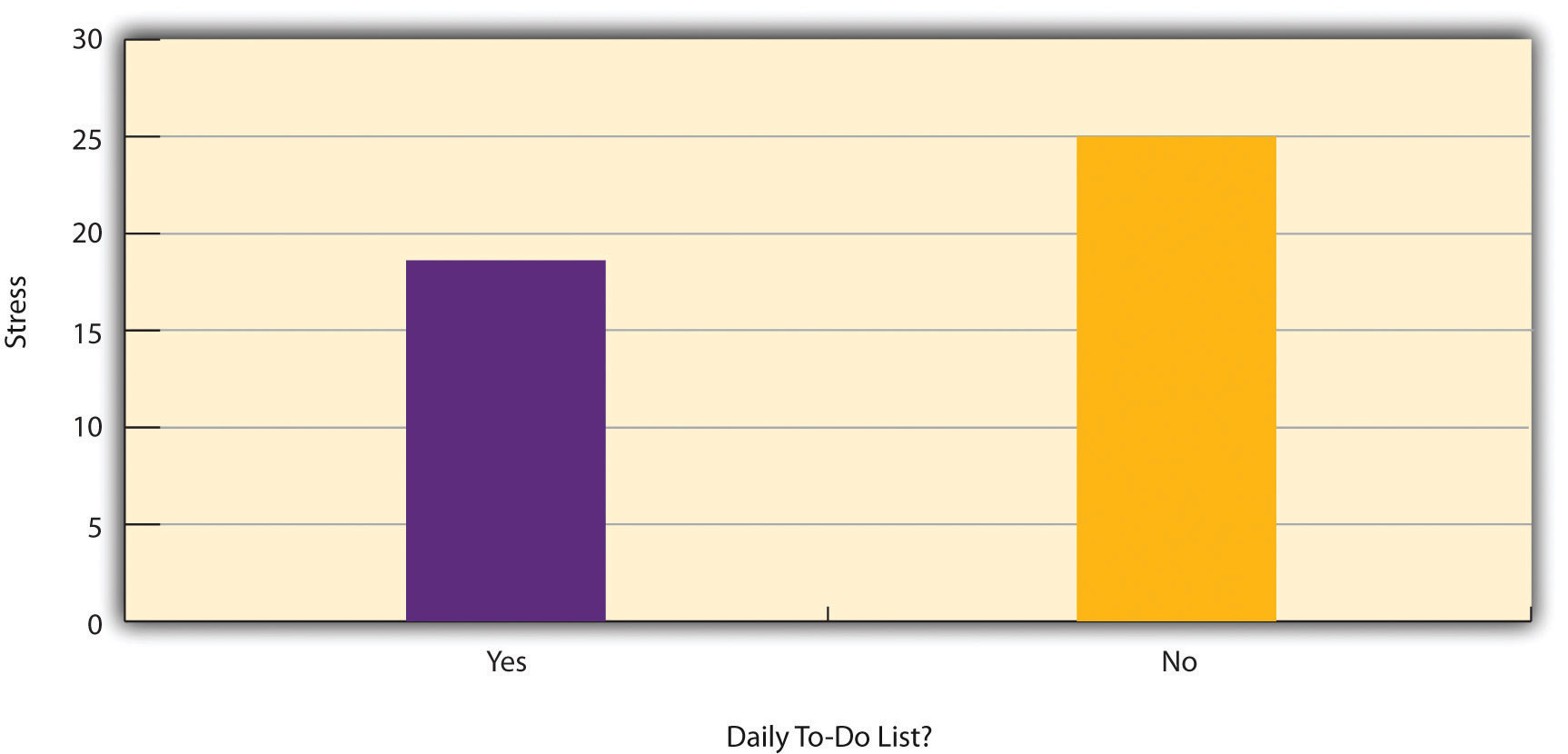

La figure 6.2 montre les données d’une étude hypothétique sur la relation entre le fait que les gens dressent une liste quotidienne de choses à faire (une « liste de choses à faire ») et le stress. Remarquez qu’il n’est pas clair s’il s’agit d’une expérience ou d’une étude corrélationnelle car il n’est pas clair si la variable indépendante a été manipulée. Si le chercheur a assigné au hasard certains participants à faire des listes de tâches quotidiennes et d’autres à ne pas le faire, alors il s’agit d’une expérience. Si le chercheur a simplement demandé aux participants s’ils faisaient des listes de tâches quotidiennes, il s’agit d’une étude corrélationnelle. La distinction est importante car si l’étude était une expérience, on pourrait conclure que le fait de dresser des listes de tâches quotidiennes réduit le stress des participants. Mais s’il s’agissait d’une étude corrélationnelle, on pourrait seulement conclure que ces variables sont statistiquement liées. Peut-être que le stress a un effet négatif sur la capacité des gens à planifier (problème de directionnalité). Ou peut-être les personnes plus consciencieuses sont-elles plus susceptibles de dresser des listes de tâches et moins susceptibles d’être stressées (problème de la troisième variable). Le point crucial est que ce qui définit une étude comme expérimentale ou corrélationnelle n’est pas les variables étudiées, ni le fait que les variables soient quantitatives ou catégorielles, ni le type de graphique ou de statistiques utilisé pour analyser les données. Ce qui définit une étude, c’est la façon dont elle est menée.

Collecte de données dans la recherche corrélationnelle

Encore, la caractéristique déterminante de la recherche corrélationnelle est qu’aucune des deux variables n’est manipulée. La manière ou le lieu où les variables sont mesurées n’a pas d’importance. Un chercheur pourrait demander aux participants de venir dans un laboratoire pour effectuer une tâche informatisée d’empan numérique arrière et une tâche informatisée de prise de décision à risque, puis évaluer la relation entre les scores des participants aux deux tâches. Il peut aussi se rendre dans un centre commercial pour interroger les gens sur leur attitude à l’égard de l’environnement et sur leurs habitudes d’achat, puis évaluer la relation entre ces deux variables. Ces deux études seraient corrélationnelles car aucune variable indépendante n’est manipulée.

Corrélations entre variables quantitatives

Les corrélations entre variables quantitatives sont souvent présentées à l’aide de diagrammes de dispersion. La figure 6.3 présente des données hypothétiques sur la relation entre la quantité de stress que subissent les gens et le nombre de symptômes physiques qu’ils présentent. Chaque point du nuage de points représente le score d’une personne pour les deux variables. Par exemple, le point encerclé de la figure 6.3 représente une personne dont le score de stress est de 10 et qui présente trois symptômes physiques. Si l’on prend en compte tous les points, on constate que les personnes soumises à un stress plus important ont tendance à présenter davantage de symptômes physiques. Il s’agit d’un bon exemple de relation positive, dans laquelle des scores plus élevés pour une variable tendent à être associés à des scores plus élevés pour l’autre. En d’autres termes, elles évoluent dans la même direction, soit toutes deux à la hausse, soit toutes deux à la baisse. Une relation négative est une relation dans laquelle des scores plus élevés pour une variable ont tendance à être associés à des scores plus faibles pour l’autre. En d’autres termes, elles évoluent dans des directions opposées. Il existe une relation négative entre le stress et le fonctionnement du système immunitaire, par exemple, car un stress plus élevé est associé à un fonctionnement plus faible du système immunitaire.

La force d’une corrélation entre des variables quantitatives est généralement mesurée à l’aide d’une statistique appelée coefficient de corrélation de Pearson (ou r de Pearson). Comme le montre la figure 6.4, le r de Pearson varie de -1,00 (relation négative la plus forte possible) à +1,00 (relation positive la plus forte possible). Une valeur de 0 signifie qu’il n’y a pas de relation entre les deux variables. Lorsque le r de Pearson est égal à 0, les points d’un nuage de points forment un « nuage » sans forme. Lorsque sa valeur se rapproche de -1,00 ou +1,00, les points se rapprochent de plus en plus d’une ligne droite unique. Les coefficients de corrélation proches de ± 0,10 sont considérés comme petits, les valeurs proches de ± 0,30 sont considérées comme moyennes et les valeurs proches de ± 0,50 sont considérées comme grandes. Notez que le signe du r de Pearson n’est pas lié à sa force. Des valeurs de r de Pearson de +,30 et de -,30, par exemple, sont tout aussi fortes ; c’est simplement que l’une représente une relation positive modérée et l’autre une relation négative modérée. À l’exception des coefficients de fiabilité, la plupart des corrélations que nous trouvons en psychologie sont de taille petite ou modérée. Le site Web http://rpsychologist.com/d3/correlation/, créé par Kristoffer Magnusson, fournit une excellente visualisation interactive des corrélations qui vous permet d’ajuster la force et la direction d’une corrélation tout en assistant aux changements correspondants du nuage de points.

Il existe deux situations courantes dans lesquelles la valeur du r de Pearson peut être trompeuse. Le r de Pearson est une bonne mesure uniquement pour les relations linéaires, dans lesquelles les points sont le mieux approchés par une ligne droite. Ce n’est pas une bonne mesure pour les relations non linéaires, dans lesquelles les points sont mieux approchés par une ligne courbe. La figure 6.5, par exemple, montre une relation hypothétique entre le nombre de nuits de sommeil d’une personne et son niveau de dépression. Dans cet exemple, la ligne qui se rapproche le plus des points est une courbe – une sorte de « U » inversé – car les personnes qui dorment environ huit heures sont généralement les moins déprimées. Les personnes qui ne dorment pas assez et celles qui dorment trop ont tendance à être plus déprimées. Même si la figure 6.5 montre une relation assez forte entre la dépression et le sommeil, le r de Pearson serait proche de zéro car les points du nuage de points ne sont pas bien ajustés par une seule ligne droite. Cela signifie qu’il est important de faire un nuage de points et de confirmer qu’une relation est approximativement linéaire avant d’utiliser le r de Pearson. Les relations non linéaires sont assez courantes en psychologie, mais la mesure de leur force dépasse le cadre de cet ouvrage.

Les autres situations courantes dans lesquelles la valeur du r de Pearson peut être trompeuse est lorsqu’une ou les deux variables ont une plage limitée dans l’échantillon par rapport à la population. Ce problème est appelé restriction de l’étendue. Supposons, par exemple, qu’il existe une forte corrélation négative entre l’âge des personnes et leur appréciation de la musique hip hop, comme le montre le nuage de points de la figure 6.6. Le r de Pearson est ici de – 0,77. Cependant, si nous ne recueillons des données que sur les jeunes de 18 à 24 ans (représentés par la zone ombragée de la figure 6.6), la relation semble être assez faible. En fait, le r de Pearson pour cette plage d’âge restreinte est de 0. Il est donc judicieux de concevoir les études de manière à éviter la restriction de la plage. Par exemple, si l’âge est l’une de vos principales variables, vous pouvez prévoir de recueillir des données auprès de personnes d’un large éventail d’âges. Cependant, comme la restriction de l’intervalle n’est pas toujours anticipée ou facilement évitable, il est bon d’examiner vos données pour détecter une éventuelle restriction de l’intervalle et d’interpréter le r de Pearson à la lumière de cette restriction. (Il existe également des méthodes statistiques pour corriger le r de Pearson en cas de restriction de plage, mais elles dépassent le cadre de cet ouvrage).

La corrélation n’implique pas la causalité

Vous avez probablement entendu à plusieurs reprises que « La corrélation n’implique pas la causalité. » Un exemple amusant de cela vient d’une étude de 2012 qui a montré une corrélation positive (r de Pearson = 0,79) entre la consommation de chocolat par habitant d’une nation et le nombre de prix Nobel décernés aux citoyens de cette nation. Il semble clair, cependant, que cela ne signifie pas que manger du chocolat amène les gens à gagner des prix Nobel, et cela n’aurait aucun sens d’essayer d’augmenter le nombre de prix Nobel gagnés en recommandant aux parents de nourrir leurs enfants avec plus de chocolat.

Il y a deux raisons pour lesquelles la corrélation n’implique pas la causalité. La première est appelée le problème de directionnalité. Deux variables, X et Y, peuvent être statistiquement liées parce que X cause Y ou parce que Y cause X. Considérons, par exemple, une étude montrant que le fait que les gens fassent ou non de l’exercice est statistiquement lié à leur degré de bonheur – de sorte que les personnes qui font de l’exercice sont en moyenne plus heureuses que celles qui n’en font pas. Cette relation statistique est cohérente avec l’idée que l’exercice physique cause le bonheur, mais elle est également cohérente avec l’idée que le bonheur cause l’exercice physique. Peut-être que le fait d’être heureux donne plus d’énergie aux gens ou les incite à rechercher des occasions de socialiser avec d’autres personnes en allant à la salle de sport. La deuxième raison pour laquelle la corrélation n’implique pas la causalité est appelée le problème de la troisième variable. Deux variables, X et Y, peuvent être statistiquement liées non pas parce que X cause Y, ou parce que Y cause X, mais parce qu’une troisième variable, Z, cause à la fois X et Y. Par exemple, le fait que les nations qui ont remporté le plus de prix Nobel ont tendance à avoir une consommation de chocolat plus élevée reflète probablement la géographie, dans la mesure où les pays européens ont tendance à avoir des taux plus élevés de consommation de chocolat par habitant et à investir davantage dans l’éducation et la technologie (une fois encore, par habitant) que de nombreux autres pays du monde. De même, la relation statistique entre l’exercice et le bonheur pourrait signifier qu’une troisième variable, telle que la santé physique, est à l’origine des deux autres. Le fait d’être en bonne santé physique pourrait inciter les gens à faire de l’exercice et les rendre plus heureux. Les corrélations qui résultent d’une troisième variable sont souvent appelées corrélations fallacieuses.

On peut trouver d’excellents et amusants exemples de corrélations fallacieuses à http://www.tylervigen.com (la figure 6.7 en fournit un exemple).

« Beaucoup de bonbons pourraient conduire à la violence »

Bien que les chercheurs en psychologie sachent que la corrélation n’implique pas la causalité, de nombreux journalistes ne le savent pas. Un site web sur la corrélation et la causalité, http://jonathan.mueller.faculty.noctrl.edu/100/correlation_or_causation.htm, renvoie à des dizaines de rapports médiatiques sur de véritables recherches biomédicales et psychologiques. De nombreux titres suggèrent qu’une relation de cause à effet a été démontrée alors qu’une lecture attentive des articles montre que ce n’est pas le cas en raison des problèmes de directionnalité et de troisième variable.

Un de ces articles porte sur une étude montrant que les enfants qui mangeaient des bonbons tous les jours étaient plus susceptibles que les autres enfants d’être arrêtés pour un délit violent plus tard dans leur vie. Mais les bonbons peuvent-ils vraiment « conduire » à la violence, comme le suggère le titre de l’article ? Quelles autres explications pouvez-vous envisager pour cette relation statistique ? Comment pourrait-on réécrire le titre pour qu’il ne soit pas trompeur ?

Comme vous l’avez appris en lisant ce livre, il existe différentes façons pour les chercheurs de résoudre les problèmes de directionnalité et de troisième variable. La plus efficace consiste à mener une expérience. Par exemple, au lieu de simplement mesurer combien de personnes font de l’exercice, un chercheur pourrait amener des personnes dans un laboratoire et assigner au hasard la moitié d’entre elles à courir sur un tapis roulant pendant 15 minutes et les autres à s’asseoir sur un canapé pendant 15 minutes. Bien que cela semble être une modification mineure du plan de recherche, elle est extrêmement importante. En effet, si les personnes qui ont fait de l’exercice ont une humeur plus positive que celles qui n’en ont pas fait, ce n’est pas parce que leur humeur a influencé la quantité d’exercice qu’elles ont fait (car c’est le chercheur qui a utilisé la répartition aléatoire pour déterminer la quantité d’exercice). De même, cela ne peut pas être dû au fait qu’une troisième variable (par exemple, la santé physique) a affecté à la fois la quantité d’exercice et l’humeur des participants. Ainsi, les expériences éliminent les problèmes de directionnalité et de troisième variable et permettent aux chercheurs de tirer des conclusions fermes sur les relations de cause à effet.

Graphique qui présente les corrélations entre deux variables quantitatives, l’une sur l’axe des abscisses et l’autre sur l’axe des ordonnées. Les scores sont tracés à l’intersection des valeurs sur chaque axe.

Relation dans laquelle des scores plus élevés sur une variable ont tendance à être associés à des scores plus élevés sur l’autre.

Relation dans laquelle des scores plus élevés sur une variable ont tendance à être associés à des scores plus faibles sur l’autre.

Statistique qui mesure la force d’une corrélation entre des variables quantitatives.

Lorsqu’une ou les deux variables ont une plage limitée dans l’échantillon par rapport à la population, ce qui rend la valeur du coefficient de corrélation trompeuse.

Le problème où deux variables, X et Y, sont statistiquement liées soit parce que X cause Y, soit parce que Y cause X, et donc la direction causale de l’effet ne peut être connue.

Deux variables, X et Y, peuvent être statistiquement liées non pas parce que X cause Y, ou parce que Y cause X, mais parce qu’une troisième variable, Z, cause à la fois X et Y.

Corrélations qui sont le résultat non pas des deux variables mesurées, mais plutôt en raison d’une troisième variable, non mesurée, qui affecte les deux variables mesurées.

.

Laisser un commentaire